评估指标记录

电子笔记

1.AUC(are under curve)

1.1什么是AUC

用于评估分类器的分类效果,对于真实类别为1的样本,分类器预测为1的概率(即TPrate)要大于真实类别为0而预测类别为1的概率(即FPrate),即AUC>0.5。

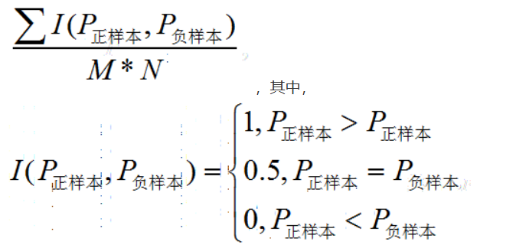

1.2如何计算AUC

在有M个正样本,N个负样本的数据集里。一共有M*N对样本(一对样本即一个正样本与一个负样本)。统计这M*N对样本里,正样本的预测概率大于负样本的预测概率的个数。

1.3接口参数含义

roc_auc_score(test_labels, probs, multi_class='ovr')

- test_labels: 实际的类别标签,shape是 [N,]

- probs: 每个样本在各个类别上的概率,shape是[N, C]

- 指定计算多类别问题的 AUC (One-vs-Rest 策略)

2.AccuracyCalculator使用

在pytorch-metric-learning中,AccuracyCalculator主要用于计算准确率(如 top-k 准确率)。通过嵌入向量之间的相似度来推测每个样本的类别,并与真实标签进行比较,相同则预测正确。这种方法是基于最近邻来判断类别,预测准确率的。

使用方法:

1 | |

3.资料

评估指标记录

http://paopaotangzu.icu/2024/12/05/6.分类评估指标/